论文理解:基于参数审计的抗Free Rider安全公平联邦学习方案

FL系统脆弱,无法抵御Free-Rider (FR) attack(搭便车攻击),这会导致隐私泄露,并降低FL系统性能,这篇论文通过隐私保护策略和贡献评估方案实现了抗Free Rider的安全公平联邦学习方案。

《PASS: Parameters Audit-based Secure and Fair Federated Learning Scheme against Free Rider》

Author:Jianhua Wang

Online Available:https://arxiv.org/abs/2207.07292

2022.7.29-ZGX

1.他们为什么做这项工作?(做这项工作的背景和目的)

FL系统脆弱,无法抵御Free-Rider (FR) attack(搭便车攻击),这会导致隐私泄露,并降低FL系统性能。现有的防御机制仅涉及FR敌手占总客户端数量少于50%的场景,且不能抵御自私FR(SFR)。

2. 针对这项工作,别人做过了哪些工作,有哪些缺陷?

以往的防御方案:

- 专注于客户端贡献评估,贡献程度通过全局更新与本地更新的相似度来衡量。这些方案认为有用的本地更新值一定和全局更新值相似。

- 缺陷:这种贡献评估的方法难以检测自私FR(SFR),SFR使用公共数据集训练模型参与联邦学习,难以检测。

贡献评估方法:

- 主要从数据质量和数据数量两方面。数据数量能够被FR伪造;传统的数据质量评估有隐私数据泄露的风险。

- Liu等总结了四种贡献评估方法:自我报告(self-report)、utility game、沙普利值(Shapley value)和个人表现(individual performance)

- 缺陷:

- 自我报告面临和数据数量评估一样的问题,容易被FR伪造;

- utility game 受参与FL系统的先后次序的影响;

- 沙普利值通信开销太大且有数据泄露风险。

- 因此,个人表现评估是四者中最直观合理的贡献评估方法。基于这个想法,我们提出了通过传输本地更新值到每一个客户端进行参数审计的贡献评估方案。

隐私保护相关工作:

- 研究发现敌手能够通过每轮训练的梯度重建出隐私输入数据。(梯度泄露攻击)

- 通过相关研究的探索和作者的实验发现,在本地侧使用方差为

、均值为0的高斯噪声可以较好地保护数据免受梯度泄露攻击侵扰(高斯LDP方案)。此外,高斯LDP对FL模型的性能影响较小。

3.他们大概是怎么做这项工作的?(一两句话概括)

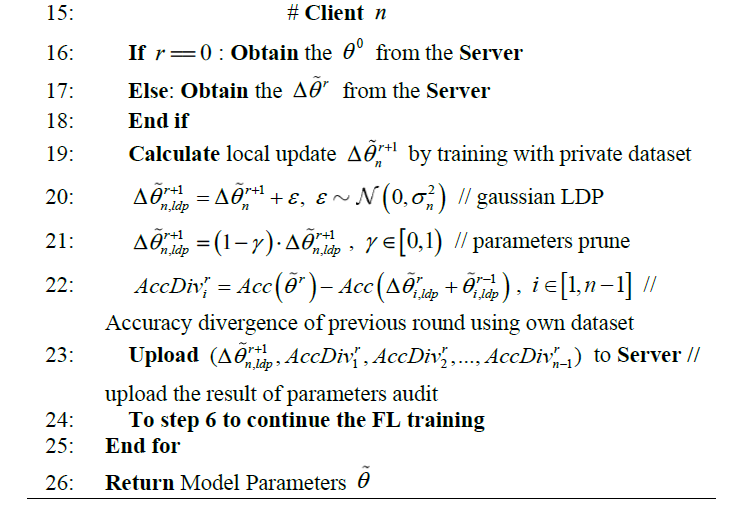

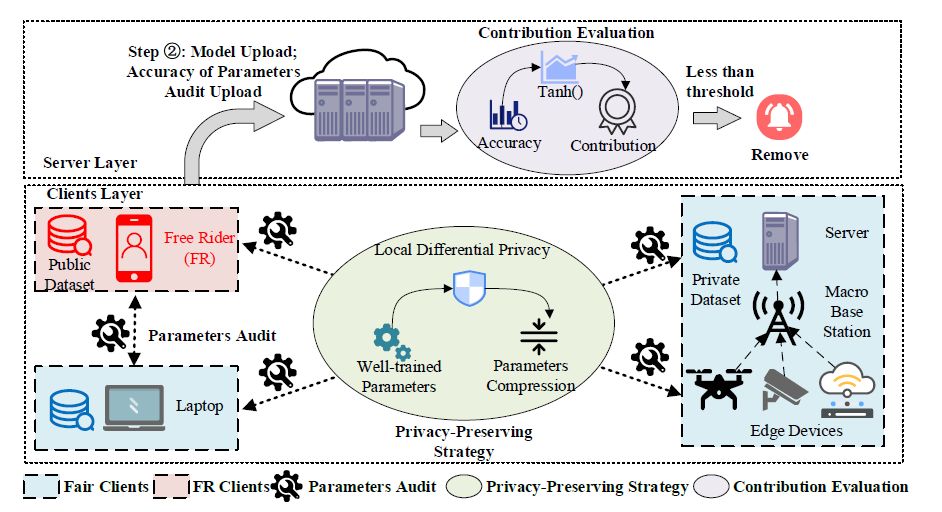

- PASS主要由两个模块组成,隐私保护策略和贡献评估。贡献值低于阈值的客户端将被淘汰。

- 贡献评估:

- 提出了基于参数审计的方案,允许每个客户端审计本地更新。

- 贡献采用Accuracy差值评估,如果贡献低于阈值,则该客户端被判断为Free Riders淘汰。

- 隐私保护策略:

采用高斯本地差分隐私对传输的参数进行保护,防止梯度泄露攻击。

同时,为了降低传输复杂度,采用参数剪枝,提供传输效率。

- 贡献评估:

4.他们的这项工作,做的好不好?好在哪里?

有如下优点:

- 在敌手占客户端总数超过50%的情况下也拥有抵抗力;

- 能有效对抗匿名FR攻击和自私FR攻击;

- 采用高斯本地差分隐私,能在几乎不损失系统准确性的情况下防止隐私泄露;

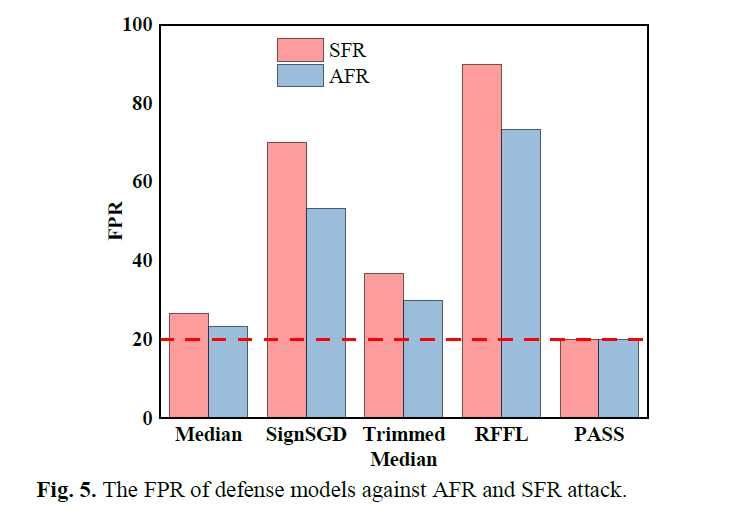

- 与同类型防御方案相比,本方案与RFFL水平相同,拥有比其他方案更低的假阳率。

5.他们这项工作,有没有不好之处,不好在哪里?

- 对于不同客户端,隐私数据集的数据分布之间可能存在差异,会影响客户端参数审计的准确度和公平性,如何削减或消除这一消极影响作者未考虑。

- 参数审计时,无法防范客户端的恶意行为,例如:

- 客户端共谋:多个恶意客户端之间互相审计时,相互包庇遮掩,上传虚假的Acc贡献值给服务器,使得服务器无法检测出非法客户端。

- 客户端污蔑:恶意客户端在审计正常客户端时,上传极低的Acc贡献值给服务器,使得服务器错误地将正常客户端判别为FR并将其淘汰。

- 没有给出防御自私FR(SFR)的针对性的设计说明。

- 隐私保护策略中的高斯本地差分隐私术沿用前人方案,没有太多创新。

6.他们的这项工作做的好,为啥好呢?他们是用什么理论证明的呢?(可能涉及方法正确性、性能、安全性)

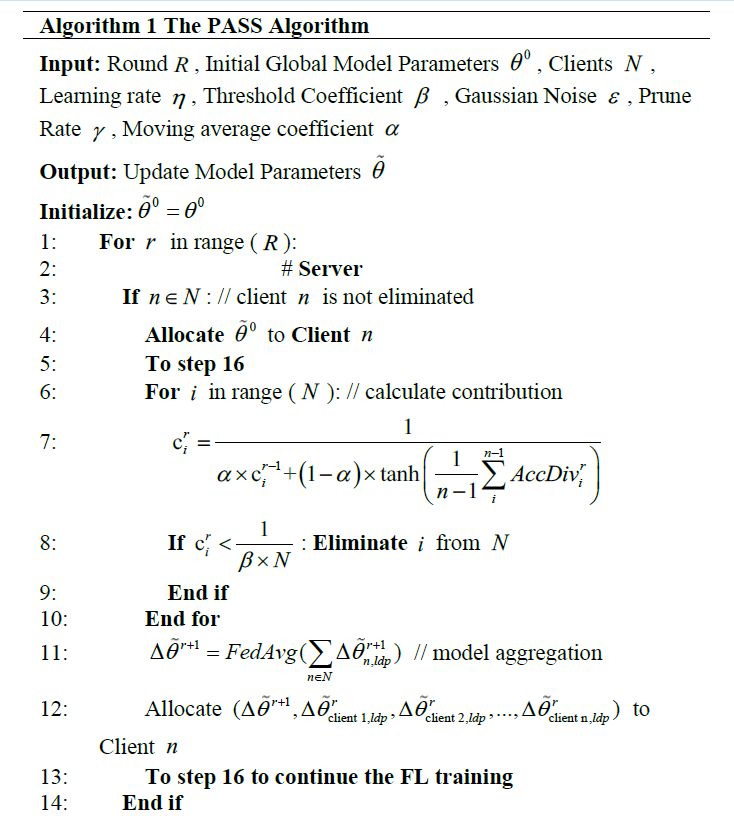

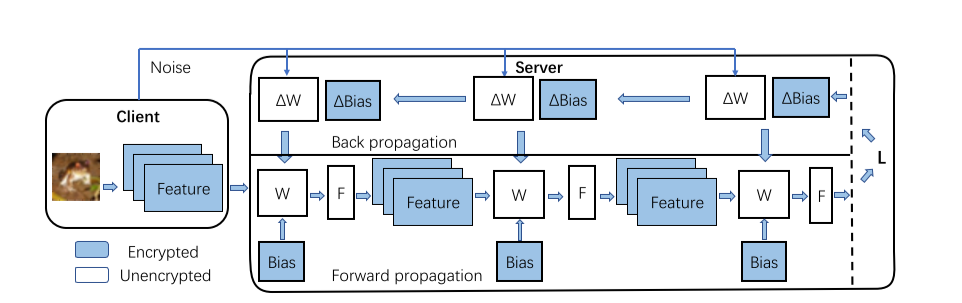

大致过程:(第r轮训练过程)

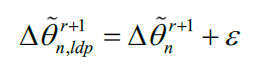

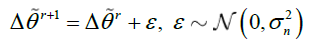

- 客户端计算本地更新:每个客户端使用隐私数据集训练本地模型,得到本地更新值

,之后对本地更新值使用高斯LDP添加噪声得到 ,发送给服务器。 - 服务器梯度聚合:通过联邦聚合算法对各合法客户端的本地更新值进行聚合,得到全局参数梯度

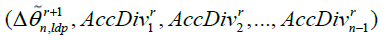

,返回给客户端。 - 服务器传递需要审计的参数:服务器会向序号为n的客户端传递序号为1~n的客户端的上一轮加噪后的本地更新值,即

,用于实现客户端参数审计。 - 客户端参数审计:客户端n接收到序号为1~n-1客户端的

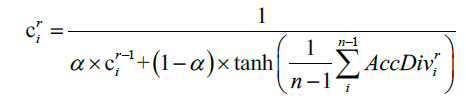

后,依次将这些参数代入模型,使用自己的隐私数据集计算全局模型与代入后模型的Accuracy差值,再将这n-1个Accuracy差值发送给服务器。 - 服务器阈值筛选:服务器接收到客户端n发送的Accuracy差值后,对客户端1~n-1计算贡献值

,淘汰贡献值低于阈值的客户端;

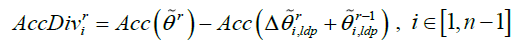

具体细节:

贡献评估:提出了基于参数审计的方案,允许每个客户端审计本地更新;

- Accuracy差值评估:在第r轮,客户端n使用自己的隐私数据集计算Accuray来对客户端i进行参数审计(i<n),用代入全局参数得到的Acc 减去代入客户端i的本地参数得到的Acc,得到客户端n对客户端i的参数审计结果。具体计算如下:

- 阈值筛选:客户端n将梯度以及对1~n-1号客户端的所有审计结果

上传到服务器,服务器进行阈值筛选,计算:

上传到服务器,服务器进行阈值筛选,计算:

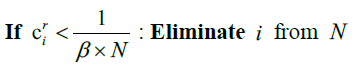

如果客户端i的

,则贡献低于阈值,该客户端被判断为Free Riders淘汰。 隐私保护策略:

高斯本地差分隐私:对传输的梯度进行保护,防止梯度泄露攻击。

其中

参数剪枝:为了降低传输复杂度,采用参数剪枝,提供传输效率

7.怎么用实验来证明他们的工作的优势?简单的说,他们是怎么设计实验的?

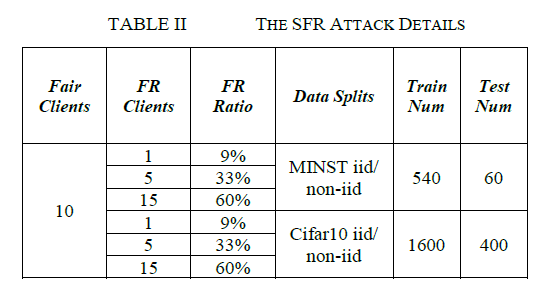

数据集:使用MNIST [27]和Cifar10 [28]作为标准分类基线数据集。MNIST 包含 10 个类的手写数字,已成为分类任务中最知名和最常用的数据集。Cifar10 由 10 类 32x32 图像和三个 RGB 信道组成,由 50,000 个训练样本和 10,000 个测试样本组成。

基线:利用目前较为先进的方法作为本实验的基线,通过与它们的对比来展现本方案的优势。

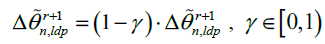

FR攻击基线:Fraboni等人提出了一种变相的搭便车攻击,使用不同回合的参数偏差和随机高斯噪声乘以几个系数,如如下方程所示。他们实现了与公平客户几乎相同的精度曲线。

防御模型基线:将RFFL、Media 、Trimmed Median 和 SignSGD 作为比较实验防御模型。

实验设置

联邦学习:模型对MNIST采用2层CNN,对CIFAR10采用3层CNN。优化器采用SGD,学习率为0.1,轮数为200,聚合算法采用联邦平均。数据集有独立同分布和非独立同分布两种。

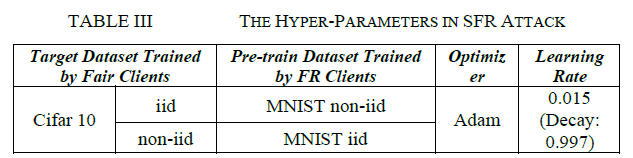

FR攻击:根据FR客户端比例不同以及数据集种类和分布不同设置多种场景:

评估指标

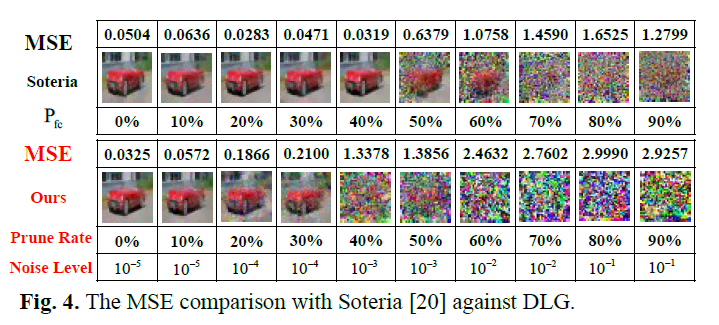

DLG(梯度泄露攻击)评估:通过重建数据和原始数据之间的均方误差(MSE)来衡量数据还原程度。MSE越高抗DLG效果越好。

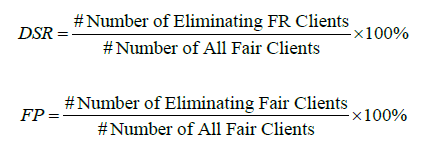

PASS评估:防御成功率(DSR)衡量防御系统有效性;误报率(FPR)衡量对SFR攻击 的防御性能,FPR表示正常客户端被移除的概率。好的系统应有较高的DSR和较低的FPR。

实验结果:

隐私保护性:

抗FR效果:

8.针对这项工作,作者未来还打算怎么做呢?具体说了哪些呢?有一些“展望”

- 暂时未发现作者明确的未来展望。

9.这项工作的idea与哪些论文有一脉相承的关系呢?或者说,你感觉这篇论文的作者是看了哪些论文,才想到这项工作的idea呢?

研究free rider attack的工作[6] [7] [8],给出了FR攻击的攻击方式和敌手假设等。

[6]Y. Fraboni, R. Vidal, and M. Lorenzi, “Free-rider Attacks on Model Aggregation in Federated Learning,” in Proceedings of The 24th International Conference on Artificial Intelligence and Statistics, Mar. 2021, pp. 1846–1854. Accessed: Dec. 07, 2021. [Online]. Available: https://proceedings.mlr.press/v130/fraboni21a.html

[7]L. Lyu, H. Yu, J. Zhao, and Q. Yang, “Threats to Federated Learning,” in Federated Learning: Privacy and Incentive, Q. Yang, L. Fan, and H. Yu, Eds. Cham: Springer International Publishing, 2020, pp. 3–16. doi: 10.1007/978-3-030-63076-8_1.

[8]L. Lyu, X. Xu, Q. Wang, and H. Yu, “Collaborative fairness in federated learning,” in Federated Learning, Springer, 2020, pp. 189–204.

[16]提出了一种经典先进的抗FR攻击方案RFFL。

[16]X. Xu and L. Lyu, “A reputation mechanism is all you need: Collaborative fairness and adversarial robustness in federated learning,” 2021.

作者自己被IEEE ISCC 2022接收的论文,在这篇文章中作者提出了一种更强的FR攻击–SFR攻击,它也是本方案的防御对象。

贡献评估的总结文献[9],总结了四种评估方法,作者一番对比之后选取了其中的个人表现评估法。

[9]H. Wang et al., “Attack of the tails: Yes, you really can backdoor federated learning,” Adv. Neural Inf. Process. Syst., vol. 33, pp. 16070–16084, 2020.

研究梯度泄露攻击的文章 [14] [20],作者从中借鉴了本地高斯差分隐私来抵御梯度泄露攻击。

[14]L. Zhu, Z. Liu, and S. Han, “Deep Leakage from Gradients,” in Advances in Neural Information Processing Systems, 2019, vol. 32. Accessed: Apr. 06, 2022. [Online]. Available: https://proceedings.neurips.cc/paper/2019/hash/60a6c4002cc7b29142def8871531281a-Abstract.html

[20]J. Sun, A. Li, B. Wang, H. Yang, H. Li, and Y. Chen, “Soteria: Provable Defense Against Privacy Leakage in Federated Learning From Representation Perspective,” 2021, pp. 9311–9319. Accessed: Apr. 07, 2022. [Online].Available: https://openaccess.thecvf.com/content/CVPR2021/html/Sun_Soteria_Provable_Defense_Against_Privacy_Leakage_in_Federated_Learning_From_CVPR_2021_paper.html

10.这篇论文的核心参考文献是?这些参考文献都起到了什么作用呢?

- 文献[9]:PASS的贡献评估模块是从该文献总结的方法中选取和加工的,采用个人表现法评估。

- 文献[14] [20]:PASS的隐私保护策略是从这两个文献当中借鉴的, 利用高斯LDP抵抗梯度泄露攻击。

11.这项工作,可以拆分为哪些子工作,哪些步骤?每个步骤,或者每个子工作使用了哪些工具或者方法去完成的呢?画一个包含步骤和工具的类似流程图的东西

PASS的架构图如下:

PASS的算法步骤图如下: